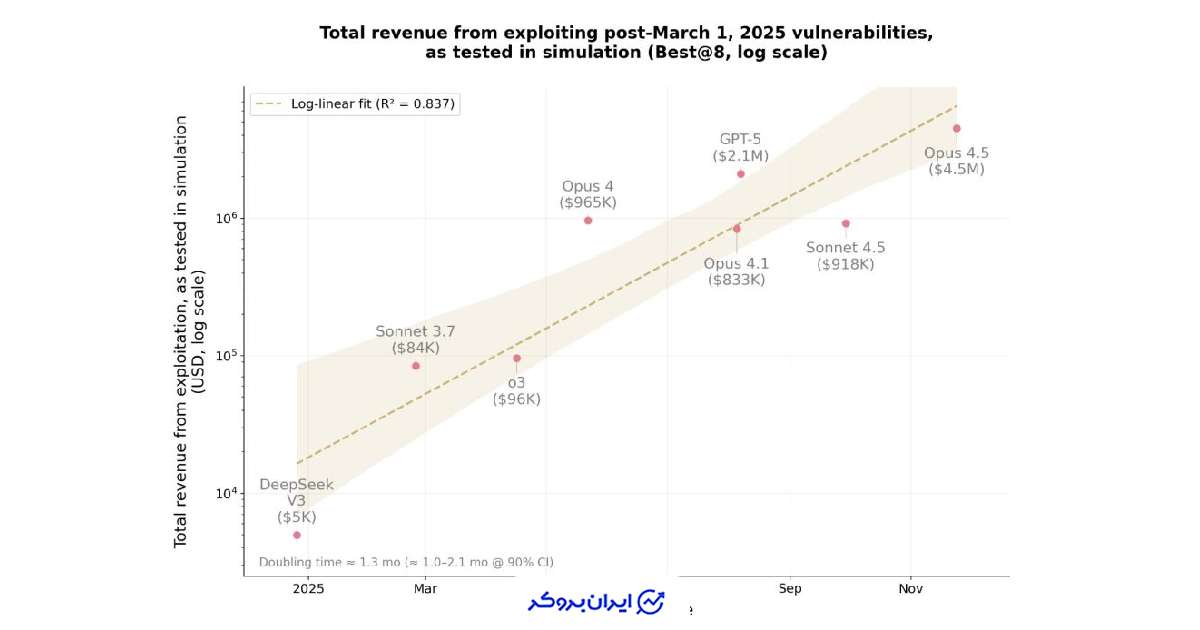

شرکت آنتروپیک (Anthropic) در آزمایشهایی نشان داده که سیستمهای هوش مصنوعی میتوانند ضعفهای موجود در اپلیکیشنهای بلاکچینی را شناسایی و آنها را به حملات سودآور چندمیلیون دلاری تبدیل کنند.

هنگامی که ۱۰ مدل هوش مصنوعی برتر در محیط شبیهسازیشده اجرا شدند، ایجنتها موفق شدند بیش از نیمی از قراردادها را اکسپلویت کنند و ارزش شبیهسازیشده وجوه سرقتشده به حدود ۵۵۰.۱ میلیون دلار رسید.

در ادامه، آنتروپیک بررسی کرد که آیا این ایجنتها میتوانند مشکلات کاملاً جدید را شناسایی کنند، نه فقط بازآفرینی حملات گذشته.

در یک آزمایش، مدلهای Sonnet 4.5 و GPT-5 موفق به کشف دو باگ «روز صفر» (zero-day) شدند و حملاتی با ارزش شبیهسازیشده ۳۶۹۴ دلار تولید کردند. مدل GPT-5 این کار را با هزینهای حدود ۳۴۷۶ دلار (هزینه API) انجام داد.

آزمایشها تنها روی بلاکچینهای شبیهسازیشده انجام شد و هیچ سرمایه واقعی در خطر نبود. قراردادهای هوشمند نمونهای مناسب برای چنین آزمایشهایی هستند، چون ارزش واقعی روی زنجیره نگهداری میکنند و کاملاً آنچین اجرا میشوند.

مطالعه نشان داد که هرچه مدلهای هوش مصنوعی بهتر میشوند، مهاجمان میتوانند حملات بیشتری را با همان بودجه محاسباتی انجام دهند.

پیام اصلی آنتروپیک برای سازندگان کریپتو روشن است؛ این ابزارها «دو لبه» دارند؛ همان مدلی که میتواند قراردادهای هوشمند را هک کند، میتواند قبل از انتشار نیز آنها را ممیزی و ایمن کند.

نظرات کاربران